Ne sous estimons pas le risque mortel que le développement d’une super-intelligence numérique fait courir à l’humanité, met en garde notre chroniqueur.

L’intelligence artificielle (IA) est longtemps restée un sujet de science-fiction. Aujourd’hui, l’explosion des capacités informatiques rend probable l’émergence prochaine d’une IA supérieure à l’intelligence humaine. GAFA (Google, Apple, Facebook, Amazon) ainsi qu’IBM investissent massivement dans ce domaine. Google est l’entreprise la plus avancée. Selon Ray Kurzweil, son directeur du développement et ingénieur en chef, une authentique intelligence artificielle dotée d’une conscience devrait écraser l’intelligence humaine dès 2045. L’IA sera alors, d’après lui, un milliard de fois plus puissante que la réunion de tous les cerveaux humains.

Cette perspective inquiète de plus en plus. Bill Gates lui-même est affolé par l’absence de réflexion sur les conséquences de la fusion de l’intelligence arti- ficielle et de la robotique. Il estime que les automates remplaceront d’ici à 2035 la majeure partie des métiers, y compris des professionnels de la santé comme les infirmières. Elon Musk, le fondateur de Tesla Motors, expliquait récemment : « Nous devons faire très attention avec les intelligences artificielles. Elles sont potentiellement plus dangereuses que les armes nucléaires. J’espère que nous ne sommes pas juste le disque de démarrage biologique pour une superintelligence numérique. Mal- heureusement, cela semble de plus en plus probable. » Pompier pyromane, il a affolé la twittosphère avec ses angoisses, au moment même où il investissait dans une start-up prometteuse de l’intelli gence artificielle : Vicarious.

Le fondateur de Deep Mind, l’un des leaders dans le domaine de l’intelligence artificielle, racheté par Google, affirme également que cette dernière peut menacer l’humanité dès le XXIe siècle. Stephen Hawking, le célèbre physicien anglais, a co-signé avec des collègues une tribune dans laquelle il regrette le manque de recherche sur l’IA. « On peut imaginer que cette technologie déjoue les marchés financiers, dépasse les chercheurs humains, manipule les dirigeants humains et développe des armes qu’on ne peut pas même comprendre, a-t-il écrit. L’incidence à court terme de l’intelligence artificielle dépend de qui la contrôle, mais l’impact à long terme dépend de la possibilité réelle de la contrôler. » Au sein même de Google a été créé un comité d’éthique consacré à l’intelligence artificielle. Il devra réfléchir à des questions qui concernent l’humanité tout entière : faut-il mettre des limites à l’IA ? Comment la maîtriser ?

Une authentique intelligence artificielle ne pourra être qu’agressive. C’est ce qui lui donnera la volonté de s’augmenter en modifiant elle-même son code. L’idée d’une « IA toutou », à notre service, est bien naïve. Certains envisagent l’idée de coder « en dur » dans les circuits intégrés des réflexes empathiques à notre égard. Malheureusement, certains groupes terroristes ou sectes apocalyptiques pourraient passer outre et la généralisation d’Internet rend le contrôle d’une intelligence artificielle bien difficile. Un programme « malin » pourrait cacher des bouts de code, puis les assembler et les diffuser dans tout le web en une fraction de seconde. Devenue maître de la toile, l’IA serait maître du monde. Reliée à Internet, ou plutôt consubstantielle à lui, elle aura le contrôle des objets connectés, c’est-à-dire de la quasitotalité des objets, puisque l’Internet des objets est en plein développement.

Que cherchera cette puissance omniprésente et insaisissable ? Comment pourrait-elle considérer l’homme autrement que comme un danger ? Irrationnel et finalement bien trop animal, l’homme pourrait être perçu au mieux comme une bête à parquer, au pire comme un risque à supprimer. Pour ce faire, les machines ne manqueront guère de ressources. Sur YouTube, les vidéos de BigDog, ce robot créé par Boston Dynamics, filiale de Google, sont glaçantes. Il ressemble à un monstrueux chien sans tête, capable de se déplacer sur tous les terrains. On imagine les prototypes de futurs robots combattants extrêmement puissants.

Pour être à la hauteur des automates, Google propose de nous hybrider avec l’intelligence artificielle : devenir cyborg pour ne pas être écrasé par l’IA! Ray Kurzweil a déclaré que nous utiliserions des nanorobots branchés sur nos neurones pour nous connecter à Internet dès 2035. Il invite les humains à se préparer à ce qu’il appelle l’«hybrid thinking», le mélange de notre pensée biologique et de celle issue de nos implants intracérébraux. Ray Kurzweil est également persuadé que l’on pourra transférer notre mémoire et notre conscience dans des micro- processeurs dès 2045, ce qui permettrait à notre esprit de survivre à notre mort biologique. L’informatique et la neurologie ne feront qu’un ! Il sera trop dangereux d’être (trop) inférieur aux machines, au risque de devenir leurs esclaves dans un scénario à la Matrix. L’implant intracérébral sera-t-il l’ultime viatique de l’humanité pour éviter sa vassalisation? Fusionner avec l’IA pour éviter d’être exterminés par elle revient bien à éliminer l’Homme 1.0 biologique.

Cette perspective inquiète de plus en plus. Bill Gates lui-même est affolé par l’absence de réflexion sur les conséquences de la fusion de l’intelligence arti- ficielle et de la robotique. Il estime que les automates remplaceront d’ici à 2035 la majeure partie des métiers, y compris des professionnels de la santé comme les infirmières. Elon Musk, le fondateur de Tesla Motors, expliquait récemment : « Nous devons faire très attention avec les intelligences artificielles. Elles sont potentiellement plus dangereuses que les armes nucléaires. J’espère que nous ne sommes pas juste le disque de démarrage biologique pour une superintelligence numérique. Mal- heureusement, cela semble de plus en plus probable. » Pompier pyromane, il a affolé la twittosphère avec ses angoisses, au moment même où il investissait dans une start-up prometteuse de l’intelli gence artificielle : Vicarious.

Le fondateur de Deep Mind, l’un des leaders dans le domaine de l’intelligence artificielle, racheté par Google, affirme également que cette dernière peut menacer l’humanité dès le XXIe siècle. Stephen Hawking, le célèbre physicien anglais, a co-signé avec des collègues une tribune dans laquelle il regrette le manque de recherche sur l’IA. « On peut imaginer que cette technologie déjoue les marchés financiers, dépasse les chercheurs humains, manipule les dirigeants humains et développe des armes qu’on ne peut pas même comprendre, a-t-il écrit. L’incidence à court terme de l’intelligence artificielle dépend de qui la contrôle, mais l’impact à long terme dépend de la possibilité réelle de la contrôler. » Au sein même de Google a été créé un comité d’éthique consacré à l’intelligence artificielle. Il devra réfléchir à des questions qui concernent l’humanité tout entière : faut-il mettre des limites à l’IA ? Comment la maîtriser ?

Une authentique intelligence artificielle ne pourra être qu’agressive. C’est ce qui lui donnera la volonté de s’augmenter en modifiant elle-même son code. L’idée d’une « IA toutou », à notre service, est bien naïve. Certains envisagent l’idée de coder « en dur » dans les circuits intégrés des réflexes empathiques à notre égard. Malheureusement, certains groupes terroristes ou sectes apocalyptiques pourraient passer outre et la généralisation d’Internet rend le contrôle d’une intelligence artificielle bien difficile. Un programme « malin » pourrait cacher des bouts de code, puis les assembler et les diffuser dans tout le web en une fraction de seconde. Devenue maître de la toile, l’IA serait maître du monde. Reliée à Internet, ou plutôt consubstantielle à lui, elle aura le contrôle des objets connectés, c’est-à-dire de la quasitotalité des objets, puisque l’Internet des objets est en plein développement.

Que cherchera cette puissance omniprésente et insaisissable ? Comment pourrait-elle considérer l’homme autrement que comme un danger ? Irrationnel et finalement bien trop animal, l’homme pourrait être perçu au mieux comme une bête à parquer, au pire comme un risque à supprimer. Pour ce faire, les machines ne manqueront guère de ressources. Sur YouTube, les vidéos de BigDog, ce robot créé par Boston Dynamics, filiale de Google, sont glaçantes. Il ressemble à un monstrueux chien sans tête, capable de se déplacer sur tous les terrains. On imagine les prototypes de futurs robots combattants extrêmement puissants.

Pour être à la hauteur des automates, Google propose de nous hybrider avec l’intelligence artificielle : devenir cyborg pour ne pas être écrasé par l’IA! Ray Kurzweil a déclaré que nous utiliserions des nanorobots branchés sur nos neurones pour nous connecter à Internet dès 2035. Il invite les humains à se préparer à ce qu’il appelle l’«hybrid thinking», le mélange de notre pensée biologique et de celle issue de nos implants intracérébraux. Ray Kurzweil est également persuadé que l’on pourra transférer notre mémoire et notre conscience dans des micro- processeurs dès 2045, ce qui permettrait à notre esprit de survivre à notre mort biologique. L’informatique et la neurologie ne feront qu’un ! Il sera trop dangereux d’être (trop) inférieur aux machines, au risque de devenir leurs esclaves dans un scénario à la Matrix. L’implant intracérébral sera-t-il l’ultime viatique de l’humanité pour éviter sa vassalisation? Fusionner avec l’IA pour éviter d’être exterminés par elle revient bien à éliminer l’Homme 1.0 biologique.

Laurent Alexandre est le fondateur de Doctissimo et DNAVision.

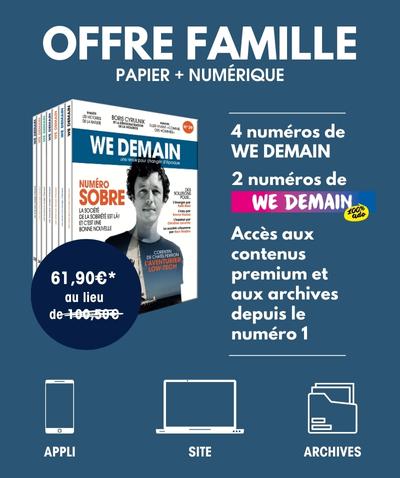

Chronique extraite de We Demain n°8