Partager la publication "La façon dont nous parlons aux robots (et aux IA) est révélatrice"

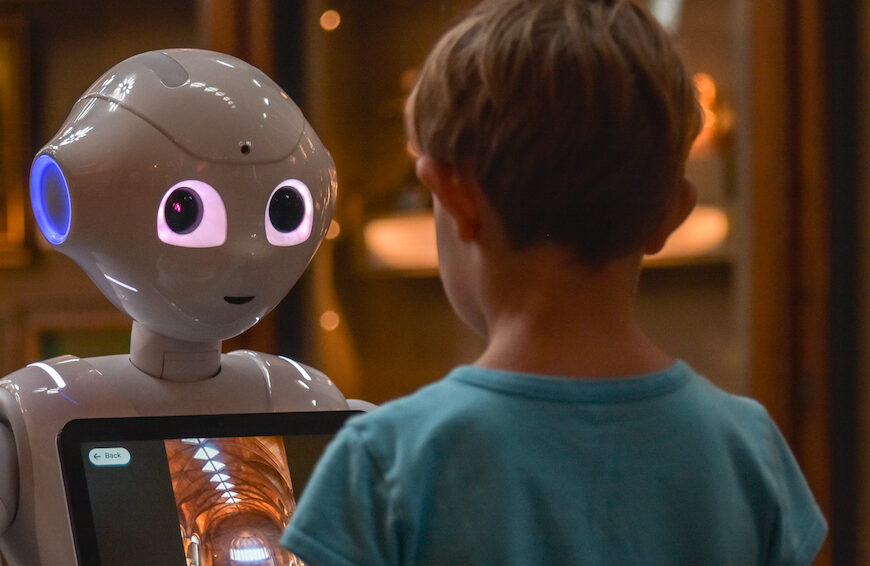

Aujourd’hui, tout le monde s’adresse à des machines et des robots à longueur de journée : de Dragon à Alexa, en passant par Siri et la dictée vocale de votre téléphone, l’interaction humain-machine est plus que jamais au cœur de notre quotidien. Pourtant, cette interaction est modulée par de nombreux paramètres, et notamment à quel point la machine ressemble physiquement à un humain.

Or comprendre comment nous interagissons avec les robots nous permet de mieux comprendre comment nous gérons l’interaction avec des interlocuteurs nouveaux (à l’échelle de l’humanité) et toujours plus nombreux, et comment nous les intégrons à notre société (par comparaison avec nos autres interlocuteurs comme nos enfants ou nos animaux de compagnie). Comprendre comment l’interaction humain-machine fonctionne pourrait aussi nous aider à nous prémunir de potentiels biais dans nos interactions avec eux : les croire humains, leur prêter une conscience qu’ils n’ont pas, pour ne citer que des exemples qui résonnent avec l’actualité.

La parole adressée aux machines

« Alexa, comment ça va aujourd’hui ? » Intuitivement, vous savez que vous ne prononcerez pas cette question de la même façon si Alexa est votre bébé de deux mois, une petite fille de cinq ans, votre amie, ou votre supérieure hiérarchique. C’est ce qu’on appelle l’accommodation à son auditoire (audience accommodation en anglais). Lorsque nous parlons à des machines, nous adaptons aussi notre langage, et l’adaptation dépend du type de machine.

La parole adressée aux machines (en anglais device-directed speech) a plusieurs caractéristiques. Nous adaptons notre prononciation. Quand nous nous adressons aux robots ou à une enceinte vocale, nous avons tendance à parler plus fort, avec une voix plus grave et moins modulée. Nous avons aussi tendance à hyper-articuler, c’est-à-dire à soigner notre prononciation. Notamment, nos voyelles seront plus longues et prononcées plus précisément que quand nous parlons à un humain.

Notre grammaire est également impactée. Nous avons tendance à faire plus de phrases et à faire des phrases plus simples qu’à des humains adultes, mais plus complexes qu’à des enfants. Par exemple, on utiliserait jusqu’à dix fois plus de subordonnées et aussi beaucoup plus de formulations passives quand on parle à un robot que quand on parle à un enfant. Ainsi, on dira au robot plutôt « La souris, qui est sortie de son trou, a été mangée par le chat » là où on dirait à un enfant « La souris est sortie de son trou. Le chat l’a mangée. »

Parallèlement, la gestuelle associée à la parole (dite gestualité co-verbale) est aussi impactée : nos mouvements de la main sont plus lents quand nous nous adressons à un enfant, et encore plus quand nous nous adressons à un robot, que quand nous parlons à un autre adulte.

Cependant, ce comportement que nous avons naturellement face aux machines n’est pas immuable. La plupart des études ont remarqué que notre comportement change au cours de l’interaction avec une machine ou des robots, même quand celle-ci ne dure qu’un quart d’heure, jusqu’à ressembler un peu plus à celui qu’on réserve d’ordinaire à nos pairs.

Cette évolution de notre usage peut aussi être mise en relation avec notre habitude de l’interaction avec des machines. Ainsi, une étude de 2010 montre que les gens qui l’utilisent pour la première fois parlent au robot beaucoup plus fort, plus aigu, et plus hyper-articulé qu’à leurs pairs, même s’ils semblent attendre des robots des compétences communicatives élaborées similaires à celles des humains.

Plus les robots ont l’air humain, plus nous les traitons comme tel

Dans une étude de 2008, un chercheur a testé 168 participants interagissant avec un avatar sur ordinateur. L’avatar pouvait avoir quatre degrés de ressemblance avec un véritable humain : il pouvait avoir une faible ressemblance, une ressemblance moyenne ou une ressemblance élevée avec un humain, ou enfin être l’image d’un véritable humain. Le chercheur a ensuite observé les réponses sociales des participants selon qu’ils ont fait confiance ou non à l’avatar lors du test, ou qu’ils ont rapporté s’être sentis proches de lui, l’avoir jugé compétent, etc. Il a ainsi montré que plus l’avatar avait l’air humain, plus il recevait de réponses sociales de la part des participants.

Plus récemment, une étude d’une équipe française sur la façon de parler à une enceinte vocale, à un robot humanoïde ou à un véritable humain a permis de mettre en lumière le fait qu’on s’adresse effectivement différemment à une enceinte vocale et à un androïde : nous parlons plus aigu et avec moins de variation dans la voix à l’enceinte qu’à l’androïde, et à l’androïde qu’à l’humain.

Cette même étude a montré que les femmes et les hommes ne se comportent pas de la même manière : en fin d’interaction, les hommes finissent par s’adresser aux robots comme ils s’adressent à l’enceinte, c’est-à-dire à un autre appareil, là où les femmes finissent par s’adresser au robot comme à l’humain. Cette différence entre les hommes et les femmes a d’ailleurs aussi été observée dans une étude où des participants s’adressent à un robot-chien.

Ce comportement linguistique reflète notre traitement cérébral de l’interaction

Dans les sciences cognitives, la capacité à attribuer des intentions et des désirs à autrui est appelée « théorie de l’esprit ». La théorie de l’esprit se développe entre 0 et 5 ans, âge auquel les enfants comprennent que la conscience des autres est distincte de la leur.

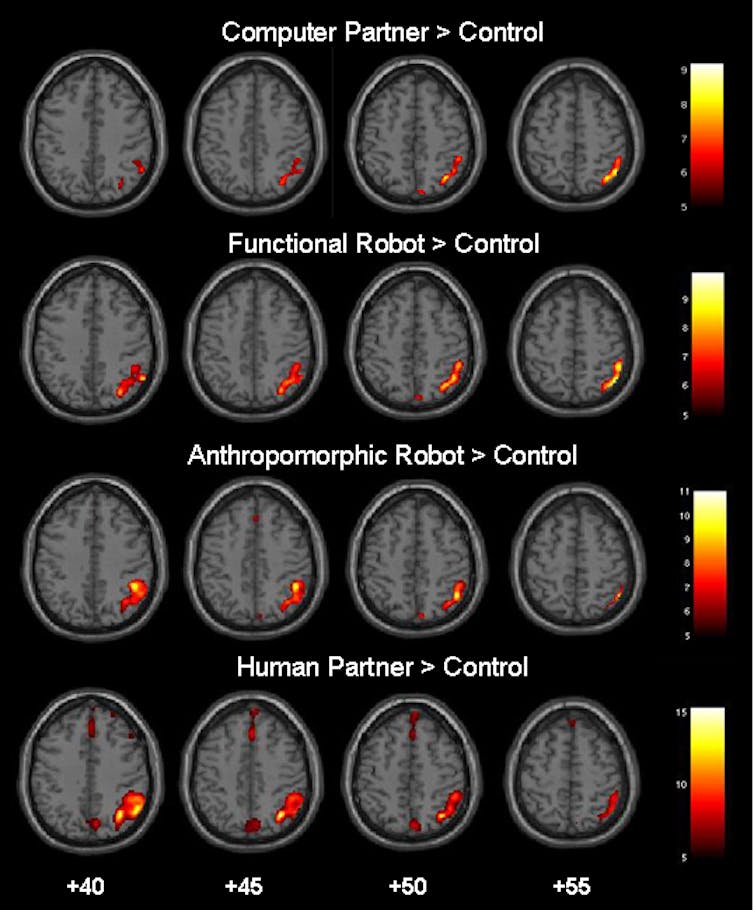

Dans une étude de 2008, une équipe allemande a montré, grâce à de l’imagerie médicale (IRM), que plus le partenaire dans la conversation ressemble à un humain, plus les parties du cerveau associées à la théorie de l’esprit sont activées.

Vingt participants ont ainsi joué à un jeu avec soit un ordinateur, soit un robot non anthropomorphisé, soit un robot humanoïde, soit un humain. Il est ressorti que plus le partenaire était semblable à un humain, plus l’IRM enregistrait une activité corticale dans le cortex frontal ainsi que dans la jonction temporo-pariétale, deux zones du cerveau activées par la théorie de l’esprit. Les participants ont aussi rapporté que plus le partenaire semblait humain, plus ils avaient ressenti de compétitivité et d’amusement.

Cependant, les études citées (et d’autres) montrent que nous opérons toujours une distinction entre un interlocuteur humanoïde et un interlocuteur proprement humain. L’aspect humanoïde des machines nous invite donc à leur adresser la parole non plus comme à des machines, mais pas tout à fait comme à des humains.

À propos de l’autrice : Mathilde Hutin. Chercheuse en sciences du langage, Université catholique de Louvain (UCLouvain).

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.